Google Lens es utilizado más de 10.000 millones de veces al mes para buscar lo que los usuarios ven, con su cámara o por medio de imágenes.

Google ha decidido salir de la caja (literalmente salir de su caja de Búsqueda). Hoy, en el evento Google en París, presentamos, entre otras cosas, una nueva forma de explorar el mundo desde el Buscador a través de texto e imágenes al mismo tiempo por medio de inteligencia artificial (IA), con Multisearch.

A partir de ahora, aunque no encuentres las palabras para describir lo que estás buscando, puedes simplemente mostrarle al buscador de Google lo que quieres encontrar, para inmediatamente tener opciones sobre dónde encontrarlo, cómo comprarlo o incluso cómo convertir esa misma idea en una posibilidad distinta.

Por ejemplo, imagina poder encontrar los horarios de servicio de una tienda con solo tomarle una foto a la fachada, o poder decirle al buscador “quiero estos tacones pero en versión flat” o “quiero este vestido rojo pero en color verde” sin necesidad de tener que encontrar las palabras exactas.

¿Cómo funciona?

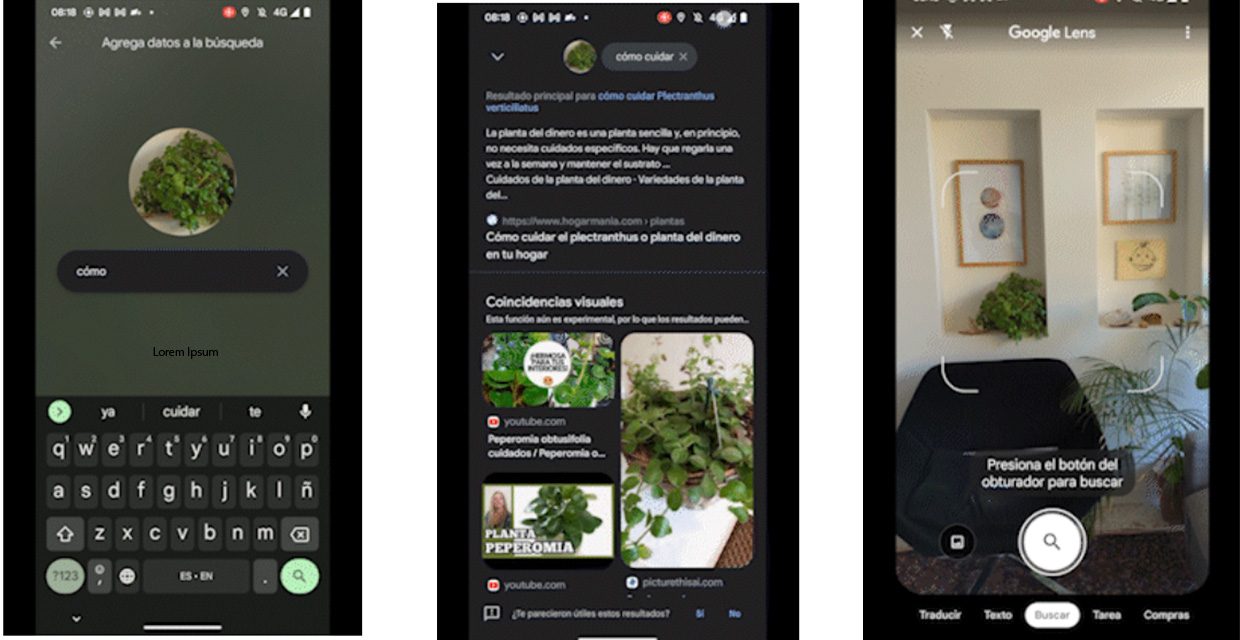

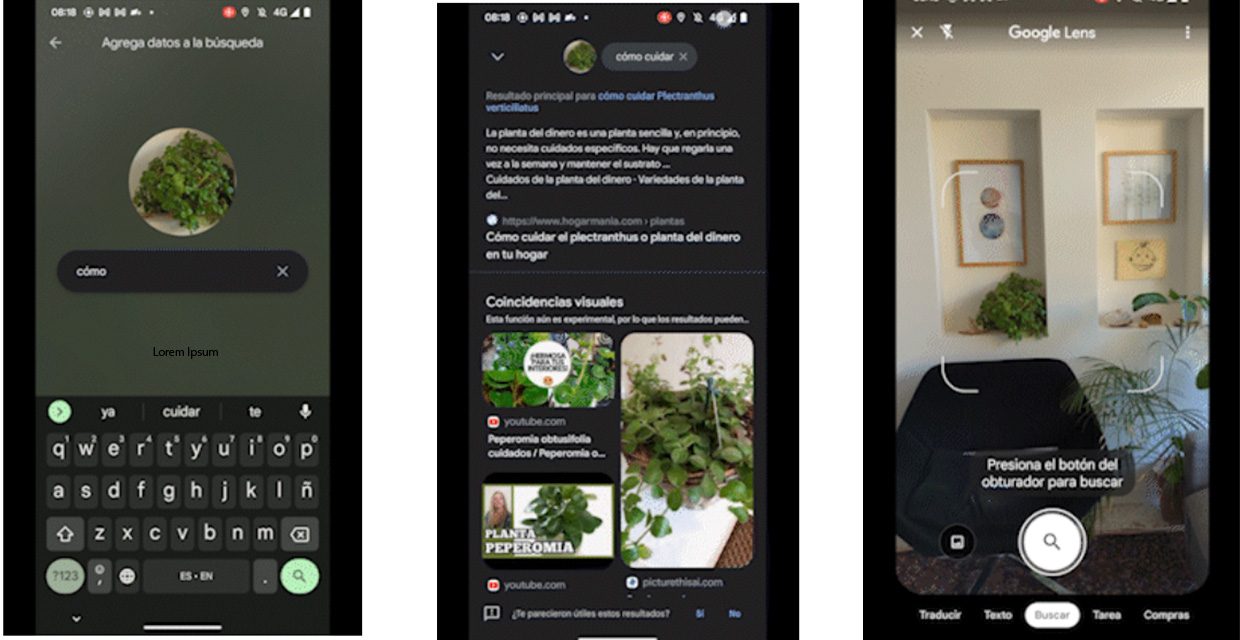

Multisearch funciona por medio de Google Lens –disponible en Android y iOS–, herramienta de IA que ya se usa más de 10.000 millones de veces al mes cuando las personas buscan en Google a través de la cámara o imágenes en su celular. Además, en los próximos meses, la multibúsqueda se expandirá a imágenes en la web a nivel mundial en dispositivos móviles. También se habilitará la función de «buscar en tu pantalla», con la cual, puedes buscar lo que ves en fotos o videos en sitios web y aplicaciones, sin tener que abandonar la aplicación o el sitio. Esta función estará en todos los idiomas en los que Lens esté disponible.

Busca de manera más intuitiva

Con esta herramienta puedes hacer preguntas sobre un objeto que tengas enfrente o delimitar mejor la búsqueda en términos de color, formas o atributos visuales que desees especificar, incluso puedes formular preguntas complejas que sin una imagen serían difíciles de explicar:

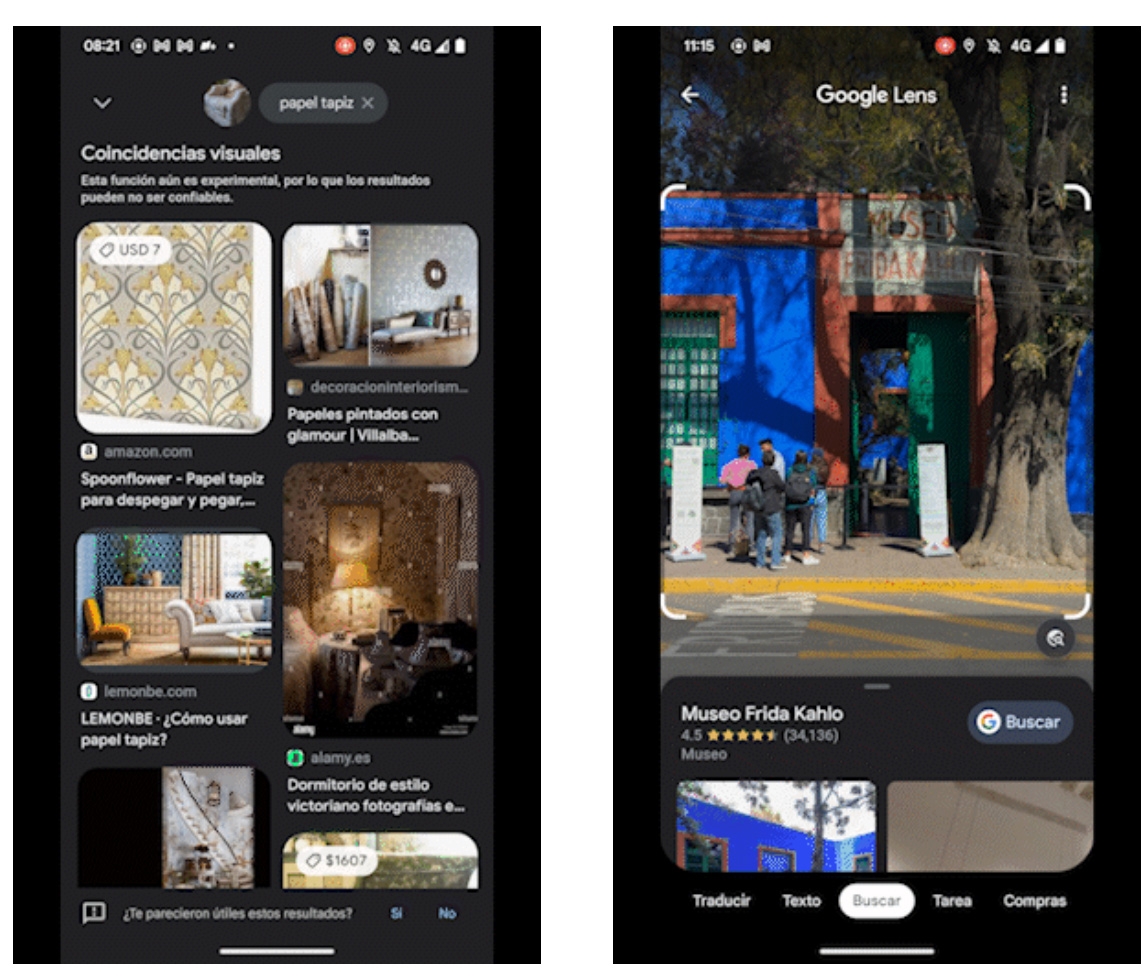

- Toma una fotografía de la tela de un sillón que te guste y busca opciones de “papel tapiz” que tengan el mismo grabado.

- Toma una foto de algún alimento, por ejemplo, de algún chile y agrega “tipo de chile”, para saber específicamente qué características tiene.

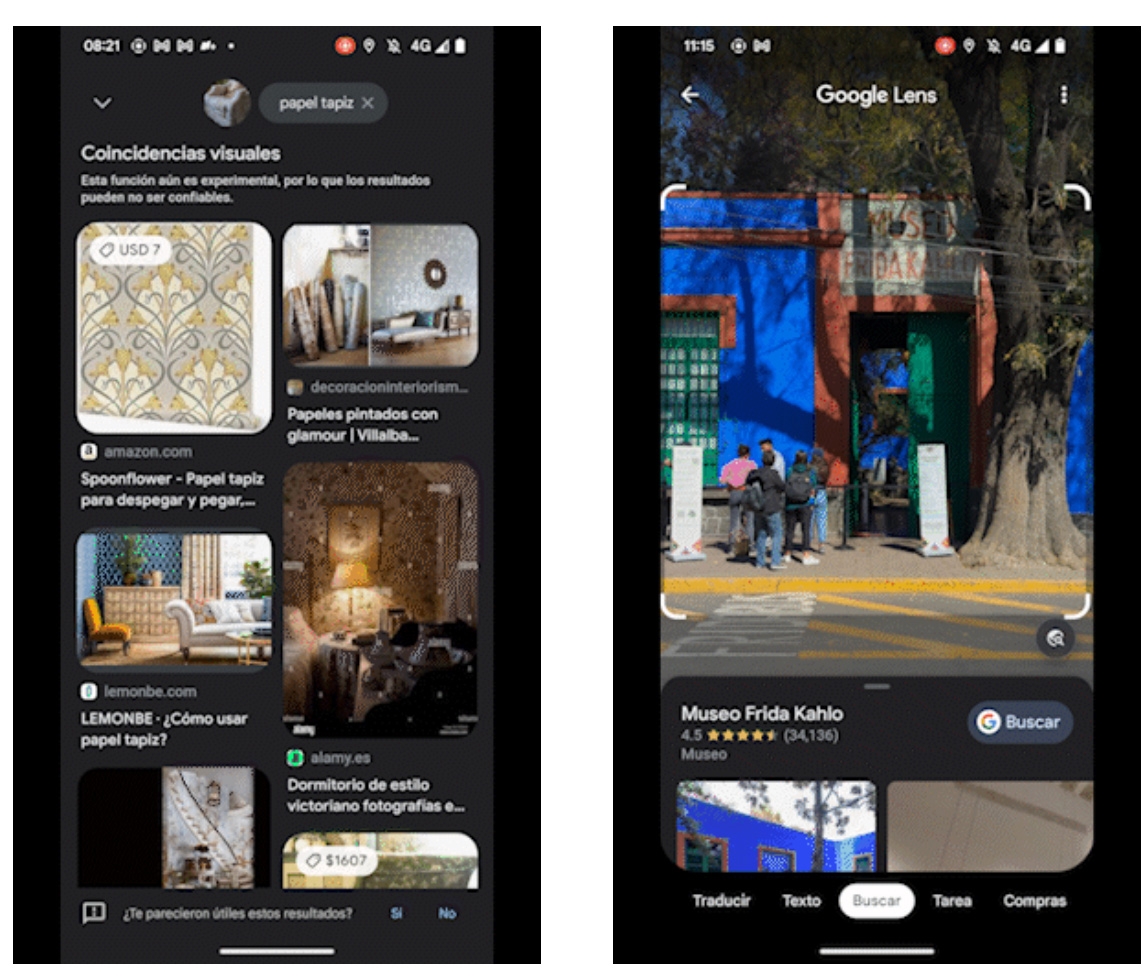

- “Toma foto de un establecimiento, por ejemplo, un museo, y añade “horarios”, para conocer el horario en que está abierto al público.

Google Maps:

Vista inmersiva: La Vista Inmersiva comenzará a implementarse desde hoy en 5 ciudades: Londres, Los Ángeles, Nueva York, San Francisco y Tokio y nos permitirá explorar dichas ciudades como si estuviéramos sobrevolando sus lugares más emblemáticos.

Live View: Live View en interiores se está expandiendo a más de 1,000 nuevos aeropuertos, estaciones de tren y centros comerciales en ciudades alrededor del mundo, incluyendo Londres, París, Berlín, Madrid, Barcelona y más.

Direcciones en un vistazo: Ahora puedes seguir tu viaje directamente desde la vista resumida de la ruta o la pantalla de bloqueo. Se visualizarán los tiempos estimados de llegada actualizados y dónde realizar el siguiente giro.

Nuevas características para aquellos conductores que manejan vehículos eléctricos con Google Maps integrado

- Estaciones de carga muy rápida: para encontrar fácilmente estaciones que tengan cargadores de 150 kilowatts o más.

- Estaciones de carga en los resultados de búsqueda: te muestra cuando lugares como un supermercado, por ejemplo, disponen de estaciones de carga.

- Agrega paradas de carga a viajes más cortos: en cualquier viaje que requiera una parada de carga, Maps sugerirá la mejor parada en función de factores clave, como el tráfico actual, tu nivel de carga y el consumo de energía esperado.

- Todas las funciones empezarán a estar disponibles en los próximos meses.

Con el paso de los años, hemos invertido cada vez más en IA para comprender de una mejor manera toda la información que se procesa por medio del Buscador, desde la comprensión del lenguaje, imágenes, videos y ahora del mundo real. Por lo que es más fácil explorar el mundo que nos rodea de forma más natural e intuitiva. Además de esto, estamos explorando maneras en las que esta función pueda estar conectada a MUM (nuestro último modelo de IA en Search) para mejorar los resultados sobre las preguntas que puedan hacerse.

Antes, tuvimos que adaptar nuestra forma de formular preguntas de acuerdo a las posibilidades y restricciones que la tecnología nos ofrecía. En el futuro que tenemos como visión, las personas seremos capaces de expresarnos con libertad y de forma cada vez más natural, para encontrar los resultados que están buscando.

- Walmart fortalece su estrategia para liderar en sostenibilidad - 22 abril, 2024

- Hospital Metropolitano recibe reconocimiento internacional por impulsar la educación médica - 22 abril, 2024

- KPMG reconocida como líder mundial en servicios de gestión de programas ASG por IDC MarketScape - 22 abril, 2024